|

|

|||||||

|

|

|

Опции темы | Оценить тему | Опции просмотра |

|

|

#11 |

|

Пользователь

Регистрация: 12.01.2009

Сообщений: 40

Вы сказали Спасибо: 0

Поблагодарили 0 раз(а) в 0 сообщениях

|

Доступно обновление программы от v1.3.2

Изменения: - Поддержка многопоточности в сервисе "Мониторинг показателей сайта" - Поддержка многопоточности в сервисе "Мониторинг позиций сайта" !!Важно Крайне не рекомендуется использовать многопоточный анализ данных без как минимум 5-7 рабочих, не забаненых поисковиками прокси серверов! Для Яндекса также желательно использование XML при многопоточной проверки данных. (Поддержка многопоточности включается в настройках нужного сервиса, по умолчанию - выключена) - Поддержка ссылок сайта в кодировки UTF-8 (включая с + кириллическими доменами) Пример: [url]http://site.zone/[/url]страница_на_русском [url]http://сайт.зона/[/url]страница_на_русском Поддержка ссылок в UTF-8 доступна как в сервисе Генерация карты сайта, так и в любом другом. - Устранены некоторые (частичные) баги - Возможность группового добавления прокси (импорт из файла) серверов в разделе управления списком прокси нужного сервиса. |

|

|

|

|

|

#12 |

|

Пользователь

Регистрация: 12.01.2009

Сообщений: 40

Вы сказали Спасибо: 0

Поблагодарили 0 раз(а) в 0 сообщениях

|

Доступно обновление программы от v1.3.4

Изменения: - Добавлен сервис "Генератор файлов robots.txt" Скрин: [url]http://forwebm.net/webmprog/pics/_275.gif[/url] Сервис предоставляет возможность легко создавать и редактировать файлы robots.txt не мучаясь с ручным написанием кода. Все манипуляции доступно совершать напрямую из дерева структуры кода. Как дополнительный инструмент сервиса - имеется возможность заранее проверить необходимую страницу на потенциальный запрет для индексации прямо в редакторе файла (строка, запрещающая индексацию после проверки подсвечивается темно синим цветом). Проверку запрета можно произвести как по всему файлу (например как это происходит при учете robots.txt в сервисе "Управление SiteMap", так и проверить по необходимому (выделенному фрагменту файла)). Сервис не имеет ограничений в не активированном приложении! |

|

|

|

|

|

#13 |

|

Пользователь

Регистрация: 12.01.2009

Сообщений: 40

Вы сказали Спасибо: 0

Поблагодарили 0 раз(а) в 0 сообщениях

|

Доступно обновление программы v1.3.5

Добавлены 3 новых инструмента: 1) Инструмент "Просмотр заголовков ответа сервера (headers)"  2) Инструмент "Whois"  2) Инструмент "Ping / TraceRoute"  Подробнее о обновлении [url]http://forwebm.net/webmprog/update/?vw=23[/url] |

|

|

|

|

|

#14 |

|

Пользователь

Регистрация: 12.01.2009

Сообщений: 40

Вы сказали Спасибо: 0

Поблагодарили 0 раз(а) в 0 сообщениях

|

Доступно обновление программы v1.3.5.1

Изменения: - Добавлен новый показатель "Регистратор домена" Показатель доступен в любом сервисе, где имеется возможность создания новых показателей. Определен как "строковый показатель". Отображает данные о регистраторе в соответствии с данными о регистраторе, которые предоставляет whois. - Добавлена поддержка добавления группы сайтов в сервис "Мониторинг показателей сайта" Добавление группы сайтов доступно из меню "Сайты" сервиса. - Добавлена поддержка добавления доменов с несуществующими сайтами в сервис "Мониторинг показателей сайта" - Внесены поправки в алгоритм проверки обновлений программы. (в версии v1.3.5 возможно отображение пустого текста при выводе информации о доступности обновлений. Последствий не несет, после обновления - текст вновь будет отображаться как раньше) |

|

|

|

|

|

#15 |

|

Пользователь

Регистрация: 12.01.2009

Сообщений: 40

Вы сказали Спасибо: 0

Поблагодарили 0 раз(а) в 0 сообщениях

|

Доступно обновление программы v1.3.5.3

Изменения: - Добавлена поддержка выбора источника(ов) данных для получения информации о сайте.  Данная опция позволяет использовать от 1 до нескольких источников для получения данных о сайте. *** Если выбран один источник - данные обрабатываются на указанном источнике, если не выбран ни один источник - данные обрабатываются стандартным для текущих данных источником, если выбрано несколько источников - данные обрабатываются всеми выбранными источниками, затем выбирается максимальный результат (увеличивает расход трафика). ** Кэш для каждого источника разный! |

|

|

|

|

|

#16 |

|

Пользователь

Регистрация: 12.01.2009

Сообщений: 40

Вы сказали Спасибо: 0

Поблагодарили 0 раз(а) в 0 сообщениях

|

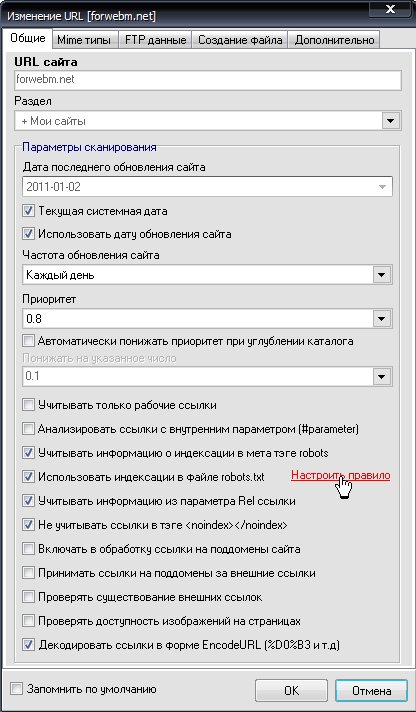

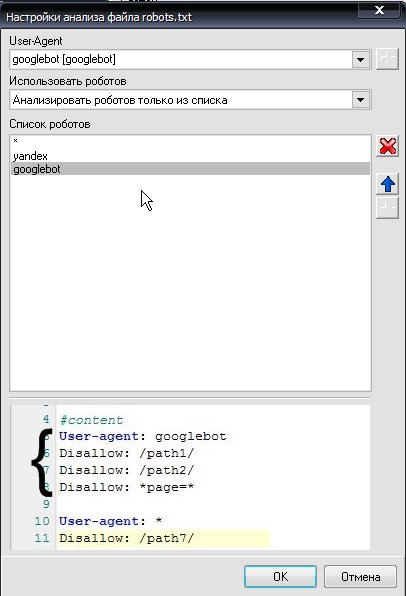

Доступно обновление программы: v1.3.5.5

Изменения: - Добавлена возможность настройки правил анализа файла robots.txt при сканировании сайта в сервисе "Управление SiteMap" Настройка правила доступна из окна добавления/изменения параметров сайта. Настройка устанавливается для каждого сайта в отдельности.  Вид окна настройки правил сканирования:  Правило позволяет установить список роботов, учет которых будет вестись при анализе запрета индексации при обходе сайта. - Если Выбрано: "Использовать для анализа весь файл" Будет анализироваться все содержимое файла robots.txt (все блоки роботов). При запрете индексации будет учтен первый из всех запретов. Весь файл также будет анализироваться при любом другом типе анализа, если список роботов пуст. - Если выбрано: "Анализировать всех роботов, кроме тех что в списке" При таком типе анализа будут участвовать в анализе запрета все блоки роботов ( например: User-Agent: yandex disallow: / allow: /page и так до следующего блока или конца файла.. ) кроме роботов, указанных в списке. - Если выбрано "Анализировать роботов только из списка" Будут учитываться блоки роботов только тех, которые указаны в списке. |

|

|

|